2022年11月にChatGPTのサービスが提供されました。チャットするようにプロンプトに質問を入力するという単純で明快なUI/UXは、多くの人に受け入れられ爆発的にユーザー数を伸ばしています。サービス公開当初から、回答の質の高さに評価が集まりました。プロンプトにいろいろな質問文を入れて回答を利用したり、少し難しい質問を入れて挙動を確認したりした方もいらっしゃるかと思います。しかし、最近になり個人情報の収集や管理、利用者の年齢を制限できないなど、これまでのAIと同様の倫理面の問題も話題にされています。AI全般についてEUでの法規制の発効も近づいています。今回は我々の生活をサポートするAIと倫理の関係について報告します。

AIの倫理とは何か?

近年のAIの応用は2010年代の深層学習を用いた研究がベースになっています。この研究は、画像、動画、音声の認識、自然言語処理、定型、非定型データの予測、分類など数多くの分野で利用されています。

2010年代のAIブーム以降、AIが人間の仕事を代替する、人間が制御できない事態を引き起こす、AIが人間にとって脅威となる、などのネガティブな話題も出てきています。これに対して世界中の産官学の団体がAIをどのように取り扱うべきかというガイドラインを検討し公表しています。

これらのガイドラインはAIの倫理も扱っており、近年はその議論が活発になっています。必ずしも法を逸脱するわけではないものの、倫理的、道義的なAIの問題に対処するために、いくつかのキーワードがAIのガイドラインに盛り込まれています。

そのキーワードは公平性、公正性、プライバシー、包摂性、透明性、説明可能性、監査可能性、頑健性、アカウンタビリティなどです。これらキーワードに関連するAIの倫理問題に対応するためにさまざまな活動がされています。ChatGPTも2010年以降のAIの進化系であり利用については倫理的な問題が同様に存在しています。

AI規制がイノベーションに与える影響について 人工知能学会全国大会 論文誌 第36回(2022)

AIが引き起こす倫理問題

現在、多くの場面で利用される深層学習をベースにしたAIシステムは、AIをベースとしていない情報システムと比べ、データ、アルゴリズム、運用の点で大きく異なります。AIシステムはデータの収集や、時には設計者が当初想定していない挙動をすることがあり、AIやAIの活用に対して倫理的な側面が注目されるようになってきました。

データに関する倫理問題

現在のAIは過去の大量のデータをもとに学習し、過去の事例の分類や未来の事象を予測するモデルを構築します。このモデルのもととなるデータが原因でAIの倫理的な問題を引き起こすことがあります。

海外の犯罪者の再犯を予測するAIシステムの学習には、犯罪や保釈の履歴、年齢、雇用状況、教育レベル、地域とのつながり、薬物使用、信条、さらに家族や友人の犯罪歴、薬物使用歴などのデータを集めているとされていますが、その詳細は明らかになっていません。過去の犯罪者の履歴をもとにしているため、学習に使用したデータの偏りで特定の属性を持つ人の再犯率を高く予測する傾向を持つこともあり得ます。こうした傾向が個人の再犯率判定の公平性に影響を与えており、倫理的な問題とされています。

アルゴリズムに関する倫理問題

現在のAIには統計的機械学習という手法が使われています。多くの変数を持つ過去のデータを大量に収集し、AIの学習モデルを作ります。この学習モデルに新規のデータを入力し、学習モデルのアルゴリズムに従い、新規のデータに対して予測などを行います。先ほど例示した犯罪者の再犯予測システムも過去のデータを利用し学習モデルを作っていると言われています。

新たな人物の再犯率を予測する際に、このAIシステムは過去のさまざまな人物の類似した属性を変数として加味したアルゴリズムを用いて予測します。この予測結果は、統計的な特性に基づいた近似解を示していると言えます。さらに現在のAIではこの近似解に多くの変数がどのように影響しているかを明確にすることは十分にはできません。これがAIのアルゴリズムがブラックボックスと呼ばれる理由と言われています。

アルゴリズムのブラックボックス化はAIを用いたシステムが倫理的な問題を起こした際に、その原因の特定を困難にします。倫理的な問題が生じても、学習データに起因するのか、学習データに基づくAIモデルのアルゴリズムに問題があるのかを明確にすることは、困難な状態にあります。

運用に関する倫理問題

アルゴリズムがブラックボックスであることは、AIの利用する立場から多くの疑問の声が上がりました。特に、運用面では、AIの判断を、何を根拠に信じてよいのか、というものが多く上がっています。そこで説明可能なAI(eXplainable AI:XAI)という技術が2018年前後から注目されています。しかし現在のXAIは、上司が部下に対して判断根拠を求めてそれに部下が満足する形で答えるような技術ではありません。

現在のXAIはAIの判断に対して、貢献した変数を提示する技術です。再犯率を判断する際に、判断に大きく影響している変数として、年齢、居住地などが提示される場合があります。XAIを利用するには、AIの判断を業務上どのように利用するかを明確にすることが必要です。新たな再犯率の予測の確からしさを判断するのに利用するか、過去の誤った判断を抽出し分析するために利用するのかで、XAIが提示した判断に貢献した変数の解釈も変わってきます。

例えば、再犯率を推測する際に、性別や居住地の貢献度をXAIで推定し何らかの補正をすることが、公平性を維持し、倫理的な問題を回避する場合もあります。運用上こうした補正を行わないことで、倫理的な問題を見過ごすことにもなります。AIの判断に対して人間がどのように関与するかが重要になってきます。AIと人間が一つの「系」となって目的を遂行する「ヒューマン・イン・ザ・ループ」によるAIの運用が、AIが倫理的な問題を未然に防ぐこともあります。

アルゴリズムと公正 科学技術社会論研究 第16号(2018)

AIシステムの利用には、データ、アルゴリズム、運用の視点での倫理的な考慮が必要になっています。次に、倫理に関する具体的な対応として、これまでのAIを使った業務であまり使われてこなかった新たなデータの利用で公平性を確保する実験と、欧州のAIの法的規制について紹介します。

AIの倫理に対する社会の対応

公平性に対する動き

データ、アルゴリズム、運用の視点でAIシステムの運営に倫理的な観点が必要であることを紹介しました。過去のデータに基づいたAIシステムは、過去の業務で判断した基準が強く引き継がれ、公平性という点での懸念があります。

金融サービスの少額ローンなどの審査にAIを使うことは、過去のローン審査を通過した人のデータを多く使うため、これまでローンを使用していない、審査を通過していない人に対して不利な審査結果が出る場合が多くあります。ローンを使ったことのない人たちは永続的にローンを受けられないことがあり得るのです。こうした問題に対して、金融包摂(ファイナンシャル・インクルージョン)の効果を検証した社会実験があります。

Profit vs. Equality? The Case of Financial Risk Assessment and A New Perspective on Alternative Data

この実験では通常のローンの審査に利用されていない、オンラインショッピングの履歴や、アプリでの通話時間やGPS情報などのモバイル履歴、ソーシャルメディアでの反応の履歴などを審査用に使っています。これらのデータをオルタナティブデータと呼びます。

実験結果では従来融資していない層にも、従来のローン審査に必要なデータ以外のオルタナティブデータを使い融資判断をすることでローン全体の収益を増加させる可能性があることも示唆されています。地域や融資商品の特殊性、サンプル数などの制約がありますが、従来のローン審査で用いないデータを用いることで、ファイナンシャル・インクルージョンの実現に言及したという点で意義のある実験です。

AIに対する法規制

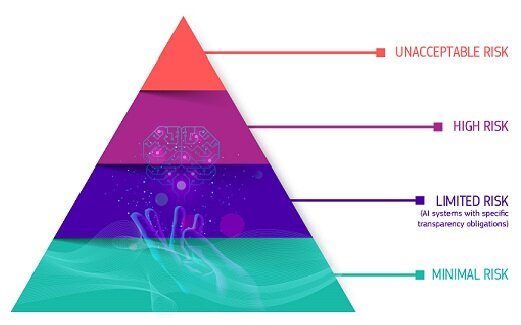

AIに対する倫理面の問題を法律規制で対応する動きもあります。EUは、GDPR(General Data Protection Regulation:一般データ保護規則)で個人データやプライバシーの保護に関して厳格な規定を行っています。そのEUがAIに対しても積極的な規制法案を2021年4月に公表しています。この規制法案の特徴は「リスクベースアプローチ」であり、AIが起こしうるリスクに応じて、規制内容を分けて適用するというものです。

この欧州発の規制はGDPRのように欧州が策定したルールが幅広く適用され、日本もその対象となることが想定されます。また、この規制を遵守しない場合のリスクはとても大きなものになるようです。 欧州委員会は移行期間を設け、事業者が具体的な基準などを準備しています。事業者向けの完全施行は最速で2024年後半が見込まれています。完全施行後にはリスクに応じたAIシステムの適合性評価が行われる予定です。

EUのAI法規制では、リスクに応じて下図のように4段階にAIのリスクを分類しています。まず、最上段の許容できないリスクのあるAIはその利用を停止するとしています。2段目のハイリスクのあるAIには法的な規制を設けます。3段目の限られたリスクのあるAIには透明性の義務を求めます。最下段にある最小限リスクのAIは特段の規制を設けません。

European Union、 https://digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai、 CCライセンス 表示 4.0 国際

(https://creativecommons.org/licenses/by/4.0/deed.ja)、 データカタログサイト利用規約 (https://digital-strategy.ec.europa.eu/en/pages/legal-notice#ecl-inpage-km0gezfs)

Regulatory framework proposal on artificial intelligence | Shaping Europe’s digital future

許容できないリスクのあるAIは利用が禁止される見込みです。具体的には下記の4つの類型に該当するものとされています。

■サブリミナルな技法

-精神的・身体的な害を生じさせ、対象者などの行動を実質的に歪めるために対象者の意識を超えたサブリミナルな技法を展開するもの禁止

(トラックドライバーに長時間運転させるために非可聴域の音を聞かせることの効果を最大にする周波数をAIで見つけるなど)

■脆弱性を利用

精神的・身体的な害を生じさせ、年齢・障害などによるグループ(子ども、障害者など)の脆弱性を利用するものの禁止

(AIの音声アシスタントが未成年者に対してゲームを装い次第に危険な行為へと駆り立てる)

■公的機関のソーシャルスコアリング

人間の信頼性評価や分類のため公的機関がソーシャルスコアを使い、人間に対して害があったり、不利な取り扱いをしたりすることの禁止

(AIが保護者の軽微もしくは無関係な社会的な不正行為(病院の予約を守らいないこと、離婚していることなど)に基づいて社会的なケアを必要とする子どもを把握する)

■法執行を目的とした公にアクセスできる場所での「リアルタイム」遠隔生体識別の禁止

公的機関や民間施設の警備など必要性もあるため具体例等で例外の明確化が必要

(テロリスト特定のためにビデオで撮影したすべての人間の顔をリアルタイムでデータベースと照合する)

許容できないリスクのあるAIの規制は、倫理的な問題を解決するうえで必要だと考えられます。「リアルタイム」遠隔生体識別の禁止は、警備などの必要性から例外も想定されています。完全施行予定される2024年までの移行期間で具体的な基準が整備されている状態であり、引き続き注視が必要です。

ハイリスクなAIとして法的な規制がかかる事例として下記のようなものが想定されています。現在実現されているAIシステムも、EUのAI法規制では、ハイリスクなAIと分類される可能性があり、のちに示す法規制で定められた適合性の評価が必要となるようです。

■人間の生体識別・分類(人間の遠隔生体識別)

■重要なインフラの管理・運営(交通管理、電気水道ガスの安全管理としてのAI使用)

■教育・職業訓練 (入学の決定、割当て、学生の評価、入試の評価)

■雇用、労働者管理、自営業者の評価(面接での評価、昇進や労務契約終了の決定、パフォーマンスや行動のモニタリング・評価)

■重要な民間・公共のサービスおよび給付へのAIの利用(公的扶助の給付やサービスを受ける人間の適格性を評価、人間のクレジットスコアの算定)

■法執行への使用(ポリグラフとしてのAIの使用、プロファイリングで犯罪・再犯予測)

■移民、難民等の庇護(難民等の庇護・査証・居住許可の申請の検討支援)

■司法の運営および民主的なプロセス(司法機関の事実・法律の調査や解釈、事実への法適用の支援)

EUのAI法規制に従うと、ハイリスクなAIシステムの要件として、システムマネジメントやデータガバナンス、セキュリティなど一定の要件を満たす必要があります。また、AIシステムを提供する側の義務として、品質管理システムの運用や適合性評価を受ける義務、是正措置・情報提供の義務なども発生します。

ハイリスクなAIシステムの提供には適合性評価を受ける必要があり、事前に適合性評価手続きを経なければならないなどの要件遵守の証明なども必要とされています。2024年に予定される完全施行に向けて、活用しているAIシステムについての状況確認が必要な場合もありますのでご留意ください。

EUのAI規制法案の概要 総務省「諸外国におけるAI規制の動向に関する調査研究」資料(2022)

経済産業省 第1回 AI原則の実践の在り方に関する検討会資料(2021)

終わりに

ChatGPTなどの新たなサービスが提供されたことにより、AIの倫理的な問題が注目されています。AIシステムの構築にはデータを大量に収集し学習することが必要です。データの収集や管理については、個人情報の取り扱いに関する倫理的な問題も発生しています。アルゴリズムのブラックボックス化も倫理的な問題を解決するうえでの課題となっています。

倫理的な問題を補正、緩和するためのAIシステムの運用や、オルタナティブデータの活用なども提案されています。また、倫理的な問題への対処としての法規制の発効も近づいています。この記事を、現在活用なさっているAIシステムに存在する倫理的な問題についてお考えいただけるきっかけにしていただければと思います。

※本記事の内容は、執筆者および協力いただいた方が所属する会社・団体の意見を代表するものではありません。

※本文および図中に登場する商品またはサービスなどの名称は、各社の商標または登録商標です。

※記事中の所属・役職名は取材当時のものです。